Supervision Apache Spark

Apache Spark est un framework de traitement de Big Data open source conçu pour la vitesse, avec des modules intégrés pour le streaming, SQL, l'apprentissage automatique et le traitement de graphiques. Apache Spark dispose d'un moteur d'exécution DAG avancé qui prend en charge le flux de données acyclique et le calcul en mémoire. Spark fonctionne sur Hadoop, Mesos, de manière autonome ou dans le cloud. Il peut accéder à diverses sources de données, notamment HDFS, Cassandra, HBase et S3.

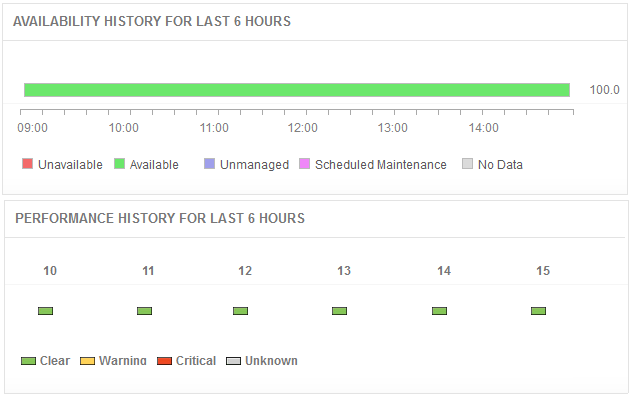

De nombreux composants sont réunis pour faire fonctionner une application Spark. Si vous prévoyez de déployer Spark dans votre environnement de production, Applications Manager peut vous assurer que vous pouvez surveiller les différents composants, comprendre les paramètres de performances, être alerté en cas de problème et savoir comment résoudre les problèmes.

Gagnez en visibilité sur les performances de Spark

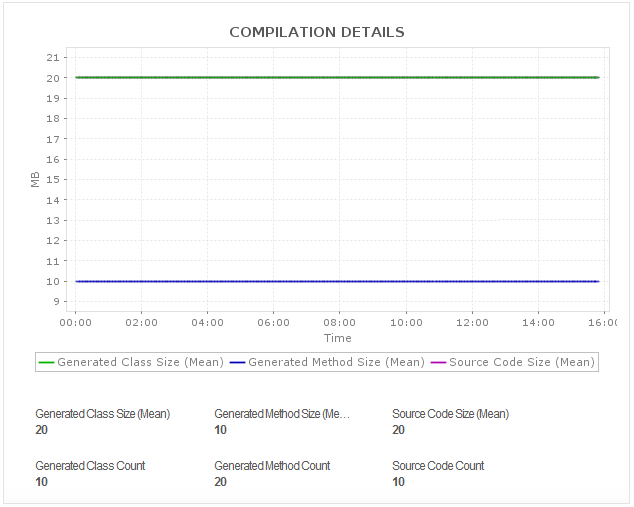

Découvrez automatiquement toute la topologie de service de votre pipeline de données et de vos applications. Effectuez une gestion complète des clusters et des nœuds en temps réel, et surveillez l'exécution des applications Spark avec la visualisation du workflow. Visualisez, en mode autonome, le maître et les nœuds de calcul s'exécutant sur des nœuds individuels et des processus exécuteurs, pour chaque application créée dans le cluster. Obtenez des informations à la seconde sur les métriques d'exécution du cluster, les nœuds individuels et les configurations.

Suivre l'utilisation des ressources

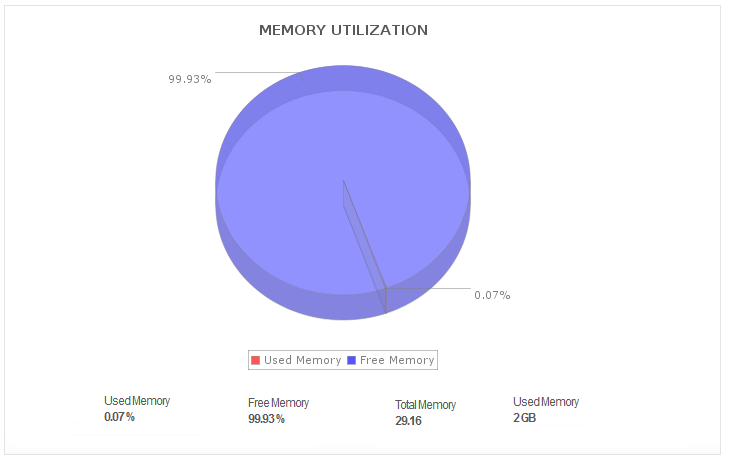

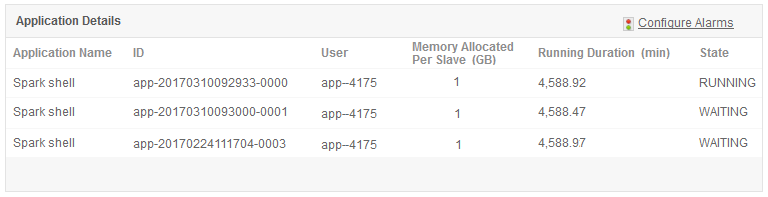

Gérez les ressources pour que vos applications Spark s'exécutent de manière optimale. Lors de l'ajout de nouveaux emplois, les équipes opérationnelles doivent équilibrer les ressources disponibles avec les priorités de l'entreprise. Restez au top de l’intégrité de votre cluster grâce à des statistiques précises sur les performances, telles que les mesures d'E/S disque et d'utilisation de la mémoire; et l’intégrité des nœuds (en temps réel) avec l'utilisation du processeur pour tous les nœuds, suivie de l'occupation du tas JVM.

Obtenez un aperçu des cœurs et des applications Spark

Obtenez des informations sur les métriques de votre application de production Spark; organiser et segmenter vos applications Spark en fonction des données définies par l'utilisateur; et trier les applications en fonction de l'état (actif, en attente, terminé) et de la durée d'exécution. Lorsqu'un travail échoue, la cause est généralement un manque de cœurs. La supervision des nœuds/travailleurs Spark fournit des métriques, y compris le nombre de cœurs libres et utilise des cœurs afin que les utilisateurs puissent effectuer une allocation de ressources en fonction des cœurs.

Comprendre les performances des RDD et des compteurs

Obtenez des métriques de performances, y compris les RDD stockés (ensembles de données distribués résilients) pour l'application donnée, l'état du stockage et l'utilisation de la mémoire d'un RDD donné, et tous les compteurs Spark pour chacune de vos exécutions Spark. Obtenez des informations détaillées sur les accès au cache au niveau des fichiers et les tâches de liste parallèle pour des optimisations potentielles des performances.

Résoudre les problèmes de performances plus rapidement

Recevez des notifications instantanées en cas de problèmes de performances avec les composants Apache Spark. Prenez conscience des goulots d'étranglement des performances et découvrez quelle application est à l'origine de la charge excessive. Prenez des mesures correctives rapides avant que vos utilisateurs finaux ne rencontrent des problèmes.