Qu’est-ce que la surveillance de Kubernetes ?

Kubernetes a révolutionné la gestion des applications conteneurisées en apportant automatisation, résilience et évolutivité. Toutefois, comprendre son architecture complexe et maintenir ses performances optimales exige une certaine expertise. Ce guide complet vous présente Kubernetes, en détaille les composants clés, met en lumière les défis liés à sa supervision dans des environnements dynamiques, et explique les indicateurs essentiels à surveiller. Que vous soyez novice en la matière ou à la recherche d’approches avancées pour optimiser la surveillance de vos clusters, vous trouverez ici toutes les clés pour assurer la stabilité, la scalabilité et l’efficacité de vos applications. Découvrez comment Kubernetes simplifie la gestion des applications tout en garantissant performance et fiabilité.

Qu’est-ce que Kubernetes ?

Kubernetes est une plateforme open source conçue pour automatiser le déploiement, la mise à l’échelle et la gestion des applications conteneurisées. Imaginez-le comme un chef d’orchestre qui coordonne les différentes parties de votre application — appelées conteneurs — pour garantir qu’elles fonctionnent ensemble, de manière fluide. Kubernetes permet à votre application de s'adapter à vos besoins et de fonctionner correctement sur différents ordinateurs.

Quels sont les avantages de Kubernetes ?

Kubernetes offre plusieurs avantages clés :

- Portabilité : Kubernetes permet d’exécuter des applications sur une large gamme d’infrastructures, qu’il s’agisse de serveurs physiques, de machines virtuelles, de cloud public, privé ou hybride.

- Évolutivité : il ajuste automatiquement le nombre de conteneurs en fonction de la charge, assurant une mise à l’échelle dynamique et efficace.

- Efficacité : grâce à une gestion intelligente des ressources, Kubernetes optimise l’utilisation du processeur, de la mémoire et d’autres composants essentiels de l’infrastructure.

- Fiabilité : avec des fonctionnalités intégrées telles que l’autoréparation et l’équilibrage de charge, il garantit une haute disponibilité et une résilience accrue.

En automatisant la plupart des tâches complexes liées au cycle de vie des applications conteneurisées, Kubernetes permet aux équipes de se concentrer sur l’innovation plutôt que sur la maintenance. C’est aujourd’hui la solution de référence pour exécuter des applications en production dans des environnements modernes, flexibles et performants.

Une plongée dans l'architecture Kubernetes

Pour surveiller et gérer efficacement un cluster Kubernetes, il est essentiel de bien comprendre les composants fondamentaux qui le composent. Examinons de plus près les éléments clés de son architecture et la manière dont ils interagissent.

Qu’est-ce qu’un cluster Kubernetes ?

Un cluster Kubernetes est un ensemble de machines, appelées nœuds, qui travaillent ensemble pour exécuter des applications conteneurisées. Il représente l’unité de base de Kubernetes et fournit l’environnement dans lequel les applications sont déployées, mises à l’échelle, gérées et surveillées.

Composants principaux d’un cluster Kubernetes

- Nœuds : unités de base de l’architecture Kubernetes, qui peuvent être des machines physiques ou virtuelles. Ce sont les ressources de calcul sur lesquelles s’exécutent les applications via des conteneurs.

- Nœud maître : véritable cerveau du cluster, il orchestre l’ensemble des opérations : gestion des nœuds de travail, planification des pods, application de l’état souhaité, etc.

- Nœuds de travail : exécutent les pods, tout en communiquant avec le nœud maître.

- Pods : ce sont les plus petites unités déployables dans l'architecture Kubernetes, représentant un groupe d'un ou plusieurs conteneurs qui partagent l'espace de noms réseau, le stockage et l'adresse IP. Ce sont les éléments de base pour le déploiement d'applications. Bien qu'ils hébergent souvent un seul conteneur, les pods peuvent accueillir plusieurs conteneurs colocalisés pour des cas d'utilisation spécifiques.

- Conteneurs : environnements d’exécution isolés contenant l’application et toutes ses dépendances. Ils constituent les unités de calcul centrales au sein des pods. Ils regroupent les applications et leurs dépendances, garantissant ainsi la cohérence et la portabilité entre les différents environnements.

- Déploiements : mécanismes de gestion du cycle de vie des pods. Ils garantissent qu’un nombre précis de réplicas est toujours actif, tout en facilitant les mises à jour et la tolérance aux pannes. Ils gèrent le processus de création, de mise à jour et de dimensionnement des pods.

- Services : abstractions réseau permettant d’exposer un groupe de pods sous une même identité. Ils assurent un point d’accès stable, l’équilibrage de charge et la découverte automatique des services.

- Espaces de noms : mécanismes de segmentation logique permettant d’isoler les ressources au sein d’un même cluster. Ils facilitent l’organisation, la gestion multi-équipes et la sécurité.

Autres composants clés de l’architecture Kubernetes

En plus des composants fondamentaux, Kubernetes comprend d’autres éléments puissants qui enrichissent son écosystème :

- ReplicaSets : garantissent un ensemble stable de répliques de pods et sont souvent utilisés en conjonction avec les déploiements.

- StatefulSets : gèrent les applications avec état en assurant un stockage persistant, un ordre de déploiement stable des pods et des identifiants réseau uniques.

- ConfigMaps et Secrets : stockent respectivement les données de configuration et les informations sensibles de manière structurée et sécurisée.

- Volumes : fournissent un stockage persistant aux pods, assurant la conservation des données au-delà du cycle de vie d’un pod.

- Ingress : expose le trafic HTTP/HTTPS vers les services du cluster, jouant le rôle de proxy inverse et d’équilibreur de charge.

Le plan de contrôle Kubernetes

Le plan de contrôle Kubernetes agit comme le système nerveux central du cluster. Il orchestre l’ensemble des opérations en assurant la gestion et la coordination des ressources du cluster. Il se compose de plusieurs composants interconnectés qui collaborent pour maintenir en permanence l’état souhaité du système. Voici ses éléments clés :

Composants principaux du plan de contrôle

- etcd : base de données distribuée clé-valeur, hautement disponible, utilisée pour stocker toutes les données critiques du cluster : configurations, secrets, états des pods, services et déploiements.

- kube-apiserver : point d’entrée principal du plan de contrôle. Il expose une API RESTful pour interagir avec le cluster, gère l’authentification, l’autorisation, et traite toutes les requêtes adressées aux ressources Kubernetes.

- kube-scheduler : sélectionne les nœuds appropriés pour l’exécution des pods en tenant compte de la charge, de la disponibilité des ressources et des règles définies. Il veille à une répartition équilibrée de la charge de travail.

- kube-controller-manager : exécute les boucles de contrôle qui comparent l’état réel du cluster avec l’état désiré. Il prend en charge la gestion des réplicas, des terminaux, des comptes de service et des événements liés aux nœuds.

Comment ils fonctionnent ensemble

Les composants du plan de contrôle Kubernetes coopèrent en continu pour garantir la stabilité et la cohérence du cluster :

- État souhaité : les utilisateurs définissent l’état attendu de leurs applications à l’aide de manifestes Kubernetes (comme les Deployments, Services ou Pods).

- Interaction API : le kube-apiserver reçoit ces manifestes, les valide et les enregistre dans etcd, la base de données du cluster.

- Planification : le kube-scheduler évalue l’état actuel des ressources et sélectionne les nœuds les plus appropriés pour héberger les nouveaux pods, selon les contraintes spécifiées.

- Gestion des contrôleurs : le kube-controller-manager veille à ce que l’état réel du cluster corresponde à l’état souhaité, en créant, mettant à jour ou supprimant des pods si nécessaire.

- Stockage de l’état : etcd conserve l’ensemble des données du cluster, assurant une récupération rapide après une panne et une cohérence permanente du système.

Les défis de Kubernetes

Kubernetes est un outil puissant, mais sa complexité et sa nature dynamique soulèvent plusieurs défis techniques susceptibles d’affecter les performances, la fiabilité et la sécurité des applications. Voici un aperçu des principaux défis rencontrés, accompagnés de solutions pratiques :

- Gestion du cycle de vie des conteneurs

- Défi : La dynamique de Kubernetes rend le suivi de l’état des conteneurs difficile dans le temps.

- Solutions:

- Exploiter les identifiants de conteneurs : Utiliser des identifiants uniques de conteneurs pour relier journaux, métriques et événements.

- Utiliser des étiquettes et des annotations : Appliquer des étiquettes et annotations pour catégoriser et filtrer les données.

- Surveiller l'état des pods et des déploiements : Suivre l’état des pods et des déploiements tout au long de leur cycle de vie.

- Complexité des systèmes distribués

- Défi : Comprendre les interactions entre microservices dans un environnement distribué peut s’avérer complexe.

- Solutions:

- Suivi distribué : Mettre en place un traçage distribué (Jaeger, Zipkin) pour suivre les flux de requêtes.

- Maillage de services : Déployer un maillage de services pour simplifier la gestion du réseau et fournir une observabilité.

- Corrélation des métriques et des journaux : Corréler logs et métriques de différents composants pour diagnostiquer plus efficacement.

- Allocation et utilisation des ressources

- Défi : Optimiser l’utilisation des ressources sans surprovisionnement ni gaspillage.

- Solutions:

- Surveillance de l'utilisation des ressources : Surveiller les métriques CPU, mémoire, E/S disque et réseau.

- Mise à l'échelle automatique : Activer l’auto-scaling pour ajuster automatiquement la charge.

- Optimisation des demandes de ressources : Optimiser les demandes/limites de ressources dans les définitions de pods.

- Gestion du réseau

- Défi : Diagnostiquer les problèmes de réseau dans une infrastructure Kubernetes complexe.

- Solutions:

- Surveillance réseau : Mettre en place une surveillance réseau pour suivre trafic, latence et pertes de paquets.

- Politiques réseau : Définir des politiques réseau pour contrôler la sécurité et l’isolation des flux.

- Stockage persistant

- Défi : Garantir la cohérence et la disponibilité des données dans un environnement à forte variabilité.

- Solutions:

- StatefulSets: Utiliser les StatefulSets pour les applications nécessitant un stockage persistant et des identités réseau stables.

- Volumes persistants : Déployer des volumes de stockage persistants pour les pods.

- Stratégies de sauvegarde et de restauration : Mettre en place des stratégies de sauvegarde et de reprise après sinistre.

- Sécurité et conformité

- Défi : Protéger le cluster et les applications des vulnérabilités et répondre aux exigences réglementaires.

- Solutions:

- Contrôle d'accès basé sur les rôles (RBAC) : Restreindre l'accès aux ressources en fonction des rôles.

- Sécurité réseau : Mettre en œuvre des politiques réseau et des pares-feux.

- Analyse des vulnérabilités : Rechercher régulièrement les vulnérabilités et corriger les systèmes.

- Surveillance de la conformité : Garantir le respect des normes de sécurité et réglementaires.

Qu'est-ce que la surveillance Kubernetes ?

La surveillance Kubernetes consiste à suivre, collecter, analyser et gérer les métriques, les journaux et les événements des clusters, nœuds, pods, conteneurs et charges de travail Kubernetes. Ce processus garantit la santé, les performances et la fiabilité des applications fonctionnant sur la plateforme Kubernetes.

Avantages de l'utilisation d'un système de surveillance Kubernetes

En tirant parti d'une solution de surveillance complète, les organisations peuvent bénéficier des avantages suivants :

- Amélioration des performances des applications : identifier et résoudre les goulots d'étranglement pour améliorer l'expérience utilisateur.

- Fiabilité accrue : détecter et résoudre les problèmes de manière proactive avant qu'ils n'affectent la disponibilité.

- Évolutivité : surveiller les événements d'évolution pour s'assurer que le cluster répond aux demandes de charge de travail.

- Optimisation de l'utilisation des ressources : éviter le surprovisionnement ou la sous-utilisation des ressources, ce qui permet de réaliser des économies.

- Meilleure visibilité : les outils de supervision centralisés offrent une vue d'ensemble du cluster Kubernetes, ce qui facilite la gestion des déploiements complexes.

Pourquoi la surveillance Kubernetes est-elle importante ?

La supervision Kubernetes est essentielle pour garantir le succès de vos charges de travail conteneurisées.

- Garantit une haute disponibilité : la supervision est essentielle pour maintenir la disponibilité et la fiabilité des applications, en veillant à ce qu'elles respectent les accords de niveau de service (SLA).

- Soutient la continuité des activités : en détectant et en atténuant les problèmes à un stade précoce, la surveillance minimise les perturbations et garantit la continuité des opérations commerciales.

- Renforce la sécurité : la surveillance permet d'identifier les activités suspectes, telles que les accès non autorisés ou l'utilisation abusive des ressources, améliorant ainsi la sécurité globale.

- Facilite la conformité : pour les secteurs réglementés, la surveillance fournit des pistes d'audit et des journaux de performances, ce qui permet de répondre aux exigences de conformité.

- Permet de prendre des décisions basées sur les données : les données historiques et en temps réel des outils de surveillance permettent aux équipes de prendre des décisions éclairées sur les améliorations à apporter aux infrastructures et aux applications.

En surveillant efficacement votre environnement Kubernetes, vous pouvez garantir la santé, les performances et la sécurité de vos applications, tout en minimisant les risques opérationnels et en maximisant le retour sur investissement.

Obtenez une vue d'ensemble des principales mesures de Kubernetes

La surveillance de Kubernetes nécessite une approche multidimensionnelle, avec le suivi des mesures de divers composants pour obtenir une vue globale de la santé du cluster et des performances des applications. Voici une ventilation détaillée des mesures essentielles :

Mesures au niveau des nœuds

- Utilisation du processeur : surveillez l'utilisation du processeur pour identifier les goulots d'étranglement des ressources et les besoins potentiels d'extension.

- Utilisation de la mémoire : suivez la consommation de mémoire pour éviter l'épuisement des ressources et assurer une exécution fluide des applications.

- E/S disque : mesurez les opérations de lecture/écriture sur disque pour évaluer les performances de stockage et identifier les goulets d'étranglement potentiels en matière d'E/S.

- Trafic réseau : surveillez le trafic réseau pour identifier les contraintes de bande passante et les problèmes potentiels du réseau.

Mesures au niveau des pods et des conteneurs

- Utilisation du processeur et de la mémoire : évaluez l'utilisation des ressources au niveau des pods et des conteneurs pour identifier les goulets d'étranglement en matière de performances et optimiser l'allocation des ressources.

- Redémarrages des pods : suivez les redémarrages des pods pour identifier les problèmes récurrents ou les problèmes de configuration.

- Disponibilité des conteneurs : surveillez la disponibilité des conteneurs pour évaluer la disponibilité et la stabilité des applications.

- Demandes et limites de ressources : assurez-vous que les conteneurs sont configurés avec des demandes et des limites de ressources appropriées pour éviter les conflits de ressources.

Mesures au niveau du cluster

- Latence du serveur API : mesurez la réactivité du serveur API Kubernetes pour évaluer les performances du cluster et identifier les goulets d'étranglement potentiels.

- Performances du planificateur : évaluez l'efficacité du planificateur dans l'attribution des pods aux nœuds afin d'optimiser l'utilisation des ressources.

- État du plan de contrôle : surveillez l'état et les performances des principaux composants du plan de contrôle (etcd, kube-scheduler, kube-controller-manager) pour assurer la stabilité du cluster.

Mesures au niveau des applications

- Latence des requêtes : suivez le temps nécessaire au traitement des requêtes par vos applications afin d'identifier les problèmes de performance et d'optimiser les temps de réponse.

- Taux d'erreur : surveillez les taux d'erreur pour identifier les défaillances des applications et résoudre les problèmes.

- Débit : mesurez le nombre de demandes traitées sur une période donnée pour évaluer la capacité et les performances des applications.

Mesures au niveau du réseau

- Latence du réseau des pods : mesurez la latence de la communication réseau entre les pods pour identifier les goulets d'étranglement liés au réseau.

- Paquets perdus : surveillez le nombre de paquets perdus pour diagnostiquer les problèmes de réseau et assurer une communication fiable.

- Application des politiques réseau : suivez l'application des politiques réseau pour garantir la sécurité et l'isolation.

Mesures au niveau du stockage

- État des volumes : surveillez l'état des volumes persistants pour garantir la disponibilité et la cohérence des données.

- Latence d'E/S : mesurez la latence des opérations d'entrée/sortie sur les volumes de stockage pour identifier les goulets d'étranglement des performances.

- Utilisation et capacité : suivez l'utilisation et la capacité de stockage pour éviter de manquer d'espace de stockage.

En surveillant ces indicateurs clés, vous pouvez obtenir des informations précieuses sur la santé et les performances de votre cluster et de vos applications Kubernetes, ce qui vous permet d'identifier et de résoudre les problèmes de manière proactive, d'optimiser l'utilisation des ressources et de garantir une expérience utilisateur fluide.

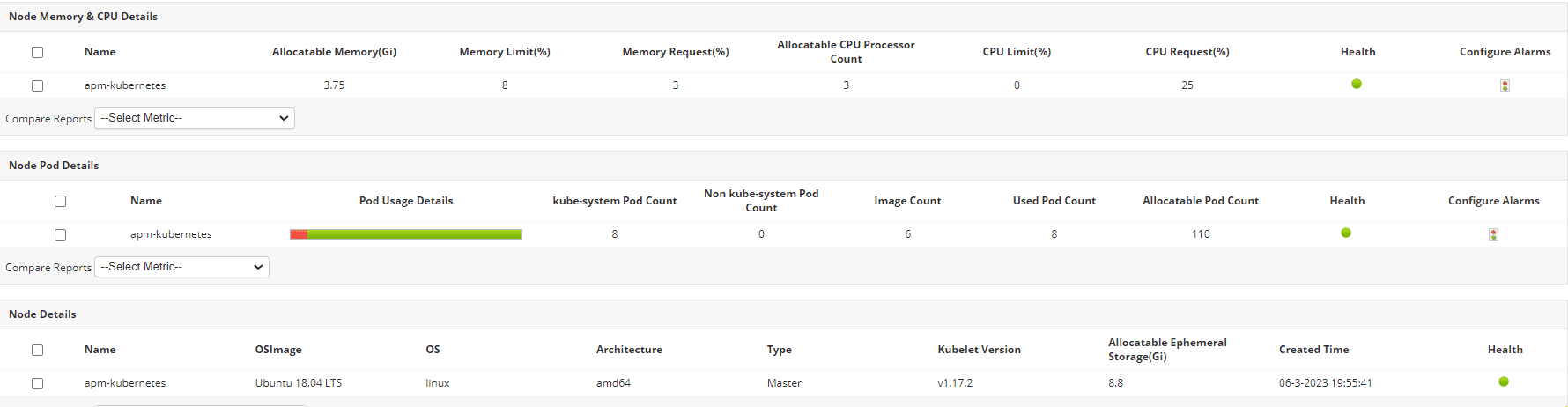

Surveillance de Kubernetes avec Applications Manager de ManageEngine

Applications Manager de ManageEngine est un outil puissant conçu pour simplifier la surveillance Kubernetes. Il offre une suite complète de fonctionnalités qui permettent de visualiser en détail la santé et les performances de votre cluster. Applications Manager s'intègre parfaitement à votre environnement Kubernetes pour collecter et analyser les données de divers composants. Il fournit une surveillance en temps réel, des alertes et des données historiques pour vous aider à prendre des décisions éclairées. Le moniteur de Kubernetes d'Applications Manager est également doté d'une interface intuitive et conviviale qui transforme des données complexes en informations exploitables.

Principales fonctionnalités du moniteur de Kubernetes d'Applications Manager

Voici quelques-unes des principales fonctionnalités de surveillance de Kubernetes proposées par Applications Manager :

- Surveillance de l'état des nœuds : Suivi de l'utilisation du processeur, de la mémoire, des E/S disque et du réseau de chaque nœud afin d'identifier les goulots d'étranglement potentiels.

- Surveillance des performances des pods : surveillez l'état des pods, la consommation des ressources et le nombre de redémarrages pour optimiser le comportement des pods et résoudre les problèmes.

- Informations sur les conteneurs : obtenez une visibilité sur la santé de chaque conteneur et l'utilisation des ressources pour identifier les conteneurs gourmands en ressources et optimiser leurs performances.

- Suivi de l'état des déploiements : suivez la progression et la santé de vos déploiements Kubernetes pour assurer une livraison fluide des applications.

- Mesures à l'échelle du cluster : évaluez l'utilisation globale des ressources, la capacité du cluster et la latence du serveur API pour la planification et l'optimisation des capacités.

Vous cherchez à surveiller vos conteneurs et applications Kubernetes ?

Rehaussez votre stratégie de surveillance de Kubernetes avec Applications Manager. Téléchargez-le dès maintenant et constatez la différence. Vous pouvez également planifier une démonstration personnalisée pour une visite guidée.