Monitoreo de Apache Spark

Apache Spark es un marco de procesamiento de datos masivos de código abierto diseñado para ofrecer velocidad, con módulos incorporados para la transmisión, SQL, machine learning y procesamiento de gráficos. Apache Spark tiene un avanzado motor de ejecución de DAG compatible con el flujo de datos acíclico y la computación en memoria. Spark se ejecuta en Hadoop, Mesos, de forma independiente o en la nube. Puede acceder a diversas fuentes de datos, como HDFS, Cassandra, HBase y S3.

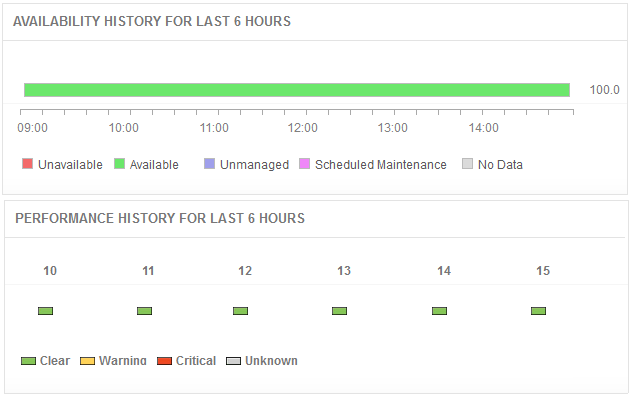

Muchos componentes trabajan juntos para hacer que una aplicación de Spark funcione. Si está planeando implementar Spark en su entorno de producción, Applications Manager puede ayudarle a monitorear los diferentes componentes, comprender los parámetros de rendimiento, recibir alertas cuando las cosas van mal y saber cómo solucionar los problemas.

Obtenga visibilidad del rendimiento de Spark

Descubra automáticamente toda la topología de servicios de su canalización de datos y aplicaciones. Gestione el cluster y los nodos, y monitoree la ejecución de las aplicaciones Spark en tiempo real con la visualización del flujo de trabajo. Visualice, en el modo autónomo, el maestro y los esclavos que se ejecutan en nodos individuales y procesos ejecutores, para cada aplicación que se crea en el cluster. Obtenga una visión actualizada de las métricas de tiempo de ejecución del cluster, los nodos individuales y las configuraciones.

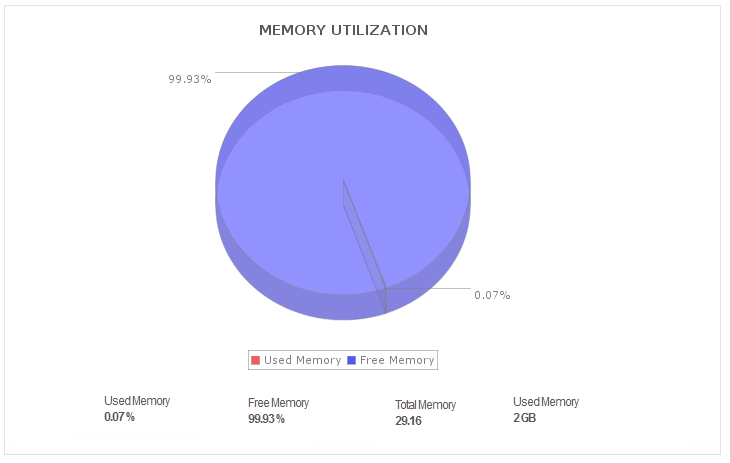

Supervise la utilización de los recursos

Gestione los recursos para que sus aplicaciones Spark funcionen de forma óptima. Al añadir nuevos trabajos, los equipos de operaciones deben equilibrar los recursos disponibles y las prioridades del negocio. Manténgase al tanto de la salud de su cluster con estadísticas detalladas de rendimiento, como las métricas de E/S de disco y uso de la memoria; y la salud de los nodos (en tiempo real) con información sobre el uso de CPU para todos los nodos, seguido de la ocupación de la pila de JVM.

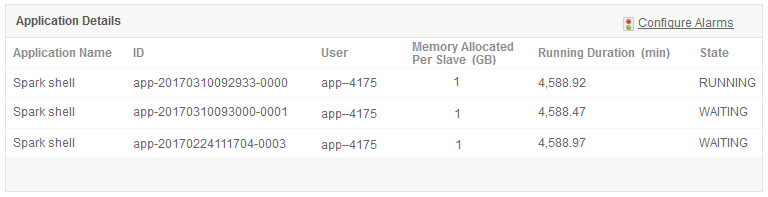

Obtenga información sobre los núcleos y las aplicaciones de Spark

Obtenga información sobre las métricas de su aplicación de producción de Spark; organice y segmente sus aplicaciones de Spark en función de los datos definidos por el usuario; y clasifique las aplicaciones en función del estado (activo, en espera, completado) y la duración de la ejecución. Cuando un trabajo falla, la causa suele ser la falta de núcleos. El monitoreo de nodos/trabajos de Spark proporciona métricas que incluyen el número de núcleos libres y utilizados para que los usuarios puedan realizar una asignación de recursos basada en los núcleos.

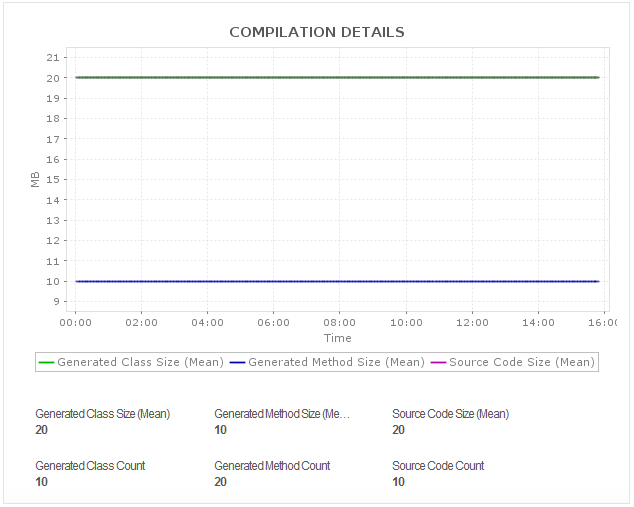

Comprenda el rendimiento de los RDD y los contadores

Obtenga métricas de rendimiento, incluyendo los RDD (conjuntos de datos distribuidos y resilientes) almacenados para la aplicación dada, el estado de almacenamiento y el uso de memoria de un RDD dado, y todos los contadores de Spark para cada una de sus ejecuciones de Spark. Obtenga una visión detallada de los aciertos de caché a nivel de archivo y de los trabajos listados en paralelo para posibles optimizaciones de rendimiento.

Solucione los problemas de rendimiento más rápido

Reciba notificaciones instantáneas cuando haya problemas de rendimiento con los componentes de Apache Spark. Identifique los cuellos de botella en el rendimiento y descubra qué aplicación está causando la carga excesiva. Tome medidas correctivas oportunas antes de que sus usuarios finales experimenten problemas.