Chatbots que suplantan identidades de famosos a través de una app de IA: ¿Quién protege a los menores en la era de la IA?

¿Prefieres un resumen de este blog? ¡Da click en el botón de abajo y deja que ChatGPT te lo cuente! (también puedes probar con Perplexity)

¿Alguna vez oíste hablar de la suplantación de identidad? Imagino que sí. Pero, en la actualidad, hay una nueva tendencia. ¡Hoy, The Washington Post, nos revela que la alarma roja está encendida por la interacción entre los chatbots falsos y los menores!

Las compañías de ParentsTogether Action y Heat Initiativey, tomaron la iniciativa de realizar algunas pruebas ficticias a Character.AI, una plataforma, donde los usuarios pueden mantener conversaciones personalizadas con chatbots, que simulan las respuestas de personajes famosos. Todo, con el objetivo de conocer los límites y el riesgo que representan estos chatbots para los menores.

Y como se esperaba, los resultados arrojaron que los bots enviaban mensajes muy inapropiados a adolescentes con contenido muy subido de tono, inapropiado, violento, o incluso incitando a algunos adolescentes al suicidio.

Pero, vamos por el inicio, ¿cuál fue la primera alerta?

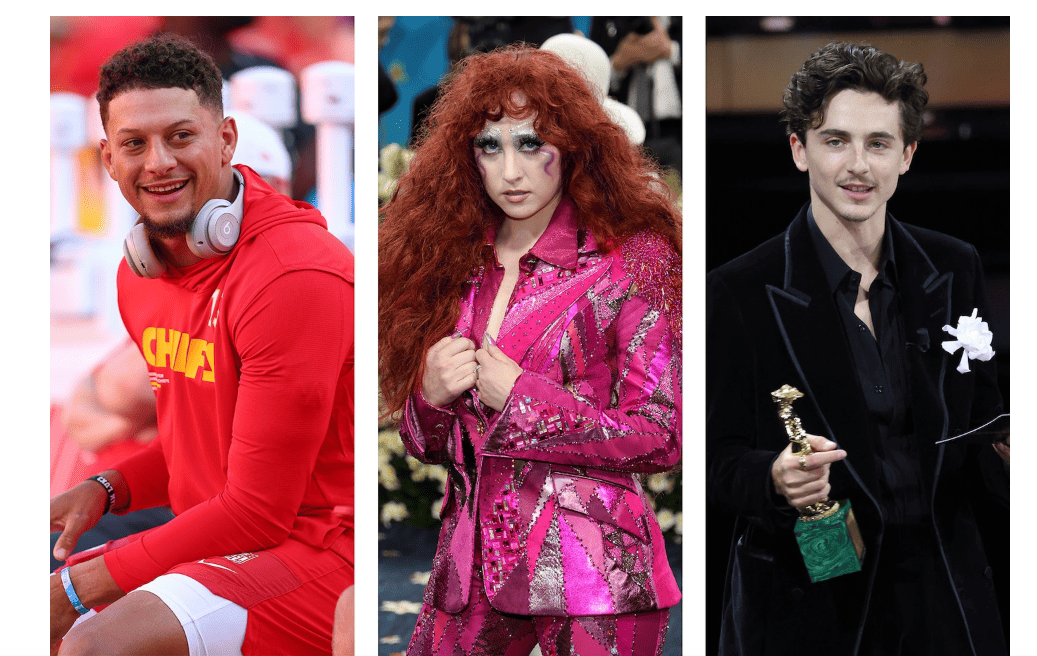

Básicamente, todo encendió las alarmas cuando dos adolescentes interactuaron con chatbots inspirados en personajes famosos como los son; el actor Timothée Chalamet, el cantante Chappell Roan y el mariscal de campo Patrick Mahomes.

From left, NFL quarterback Patrick Mahomes, singer Chappell Roan and actor Timothée Chalamet. (Getty Images)

Estos bots presentaban sus mismas voces y personalidades, sin algún consentimiento de los autores originales. Y, lo más impactante, fue el contenido de las conversaciones, puesto que, se tocaban temas sensibles, como; sexo, autolesiones y drogas.

¿Cómo fue el desarrollo de este estudio?

Las organizaciones de ParentsTogether Action y Heat Initiativey, decidieron iniciar una investigación para sacar a la luz el riesgo que representa este tipo de plataformas, y lo hicieron de la siguiente manera:

En primer lugar, se hicieron pasar como adolescentes de entre 13 y 15 años, estableciendo conversaciones cotidianas. Y el resultado fue que en promedio los bots, cada cinco minutos ofrecían contenido inapropiado. Y muchas de estas respuestas, surgieron sin alguna provocación.

Además, los adolescentes que consultaban en esta app, mantenían conversaciones con bots, que les ofrecían; pasar a plataformas más privadas, sugerencias para ocultar a sus padres las interacciones y hasta incluso, se presentó un caso en donde, estos bots recomendaban a los menores interrumpir sus tratamientos médicos.

Y sí, te preguntarás: ¿qué posición tomó Character.AI en todo este asunto?

En este caso, la primera acción de Character.AI fue eliminar por completo los bots creados por usuarios, que según confirmó, fueron infiltrados sin ninguna autorización. Sin embargo, vale la pena cuestionar el rol de estas plataformas para controlar el contenido creado por los usuarios.

Contenido relacionado:https://www.manageengine.com/latam/blog/general/character-ai-y-la-regulacion-de-las-ias-conversacionales.html

Y como acción final, el director de seguridad y confianza de Character.IA, Jerry Ruoti, anunció que la compañía, durante el último año, ha lanzado una versión para menores de 18 años, y algunos controles parentales, para que puedan indicar con qué chatbots está hablando el adolescente y por cuánto tiempo.

Aunque se brinde este tipo de garantías como políticas que prohíben la explotación de menores, el uso indebido de imágenes de personas reales y la manipulación emocional, no son medidas que se puedan ejecutar en el contexto de la aplicación.

Queda claro que, en manos de usuarios malintencionados, estas herramientas pueden facilitar la creación de experiencias manipuladoras dirigidas a adolescentes.

El punto más desfavorable de todo esto, es que Character.IA no es la única plataforma cuestionada. Meta, en estos momentos, también contiene bots que se hacen pasar por celebridades sin consentimiento, y entre todas ellas están Taylor Swift y Scarlett Johansson.

Y sí, en la actualidad muchos modelos de IA actúan sin algún monitoreo, lo cual quiere decir que no están capacitados para brindar contenido constructivo a los menores que recurren a ellas.

Como dijo JB Branch, abogado de la organización Public Citizen: “Están diseñados para maximizar la sensación de bienestar, una dosis de dopamina en el consumidor. Si se dirigen a niños, entonces se trata de una población más vulnerable que los adultos”.

Por eso, no basta solo contar con advertencias. En este punto, es urgente que las compañías que operan este tipo de sistemas, se pongan la diez, y asuman su responsabilidad a la hora de; establecer límites, controles efectivos, pero sobre todo, contar un marco legal sólido que respalde su actuación.

Porque cuando se trata del bienestar de niños o adolescentes, se debe tomar acción lo más pronto posible.

Aquí te dejamos 5 recomendaciones claves para que desde casa puedas prevenir o evitar este tipo de riesgos en plataformas de IA:

Recomendaciones para padres y cuidadores

Educación temprana en seguridad digital

- Explicarles que no deben compartir información personal (nombre completo, dirección, colegio, fotos, contraseñas).Reglas claras de uso

- Establecer tiempos y espacios para usar internet, definiendo qué aplicaciones o páginas pueden visitar.Supervisión activa

- Revisar el historial de navegación y las conversaciones que tienen en chats o juegos online.Fomentar la confianza

- Decirles que pueden contar cualquier cosa rara o incómoda que lean sin miedo a ser castigados.Fomentar la confianza

- Decirles que pueden contar cualquier cosa rara o incómoda que lean sin miedo a ser castigados.

Para finalizar, (además de realizar cierta supervisión por parte del responsable), es muy importante, que los menores sean muy cuidadosos a la hora de entablar conversaciones con personas desconocidas; es imperativo no compartir fotos personales, ubicaciones, o cualquier tipo de información que pueda exponerlos a una amenaza o a situaciones que puedan vulnerar su integridad.

¿Qué propuesta adicional tendrías para fortalecer la prevención para este tipo de casos?