AI Agentic Security: Risiko, Best Practice, dan Pendekatan Keamanan IT

AI sekarang tidak hanya menganalisis atau memberi rekomendasi. Di banyak organisasi IT, AI mulai bertindak secara mandiri memantau sistem, mengambil keputusan, hingga menjalankan aksi tanpa menunggu perintah manual, yang dikenal sebagai agentic AI.

Kemampuan ini jelas membantu tim IT bekerja lebih cepat dan efisien. Masalahnya, ketika AI sudah bisa bertindak sendiri, siapakah yang akan memastikan setiap aksinya tetap aman dan sesuai kebijakan?

Artikel ini akan membahas secara sederhana apa itu AI agentic security, risiko yang perlu diwaspadai, dan bagaimana organisasi dapat tetap menjaga kontrol saat AI mulai bekerja lebih mandiri.

Mengapa agentic AI menjadi tantangan keamanan baru?

Selama bertahun-tahun, keamanan IT dibangun dengan asumsi bahwa keputusan kritis selalu dibuat oleh manusia, sementara sistem otomatis hanya menjalankan perintah yang sudah ditentukan. Pola ini mulai berubah seiring berkembangnya agentic AI.

Agentic AI tidak hanya menganalisis atau memberi rekomendasi. Sistem ini mampu menentukan langkah berikutnya, mengkorelasikan dengan tool lain, dan mengeksekusi perintah secara mandiri berdasarkan tujuan yang ditetapkan. Dalam konteks operasional IT dan keamanan, kemampuan ini mempercepat respons dan mengurangi beban kerja manual.

Ketika AI memiliki akses ke banyak sistem dan berjalan secara otomatis, risiko tidak lagi terbatas pada kesalahan konfigurasi manusia, tetapi juga pada keputusan AI yang tidak sepenuhnya selaras dengan kebijakan, konteks bisnis, atau kebutuhan kepatuhan. Aksi yang tampak benar secara teknis bisa menjadi masalah jika dilakukan tanpa kontrol yang memadai.

Di hybrid infrastructure, multi-cloud, dan berbagai tools keamanan, satu keputusan AI yang keliru dapat:

Menyebabkan perubahan konfigurasi penting tanpa validasi

Menjalankan aksi beruntun yang sulit dihentikan

Menciptakan blind spot dalam logging dan audit

Menyulitkan tim keamanan untuk menjawab pertanyaan sederhana: siapa melakukan apa, dan mengapa?

Jenis risiko dan ancaman dalam lingkungan agentic AI

Ketika AI mulai bertindak secara mandiri, jenis risiko yang muncul tidak lagi sama dengan sistem otomatisasi tradisional. Tantangan utamanya bukan hanya pada apa yang dilakukan AI, tetapi bagaimana dan sejauh mana AI diberi kewenangan untuk bertindak. Semakin besar otonomi yang diberikan, semakin penting kontrol dan tata kelola yang jelas agar keputusan otomatis tidak berubah menjadi sumber risiko baru.

Berikut beberapa risiko utama dalam lingkungan agentic AI:

1. Akses berlebihan (Over-Privileged Access)

Agar bisa bekerja secara efektif, agentic AI sering diberi akses ke banyak sistem sekaligus mulai dari infrastruktur, aplikasi, hingga data sensitif. Tanpa pembatasan yang ketat, AI dapat menjalankan aksi dengan hak akses yang terlalu luas, bahkan melebihi kebutuhan operasionalnya.

Risikonya, satu keputusan yang keliru tidak hanya berdampak lokal, tetapi bisa memengaruhi sistem kritis secara menyeluruh. Dalam skenario tertentu, kesalahan kecil dapat langsung memicu gangguan layanan, perubahan konfigurasi penting, atau eskalasi akses yang tidak diinginkan.

2. Aksi otomatis tanpa validasi konteks

Agentic AI mengambil keputusan berdasarkan data, aturan, dan pola yang dipelajarinya. Namun, tidak semua konteks bisnis, kondisi darurat, atau pertimbangan kepatuhan dapat sepenuhnya diterjemahkan ke dalam logika sistem. Dalam praktiknya, keputusan yang terlihat efisien dari sudut pandang sistem bisa menimbulkan konsekuensi operasional atau kepatuhan jika dijalankan tanpa validasi tambahan.

Tanpa mekanisme kontrol atau human-in-the-loop, AI berpotensi:

Menjalankan aksi yang secara teknis benar

Namun tidak selaras dengan kebijakan internal, prioritas bisnis, atau kebutuhan regulasi

3. Tindakan beruntun yang sulit dikendalikan

Karena agentic AI mampu menjalankan tugas multi-langkah, satu keputusan awal dapat memicu serangkaian aksi lanjutan secara otomatis. Aksi ini sering kali saling bergantung dan berjalan dalam waktu singkat, sehingga sulit untuk dihentikan di tengah proses. Semakin kompleks workflow otomatisasi, semakin tinggi kebutuhan akan kontrol dan visibilitas real-time.

Jika tidak dipantau dengan baik, kondisi ini dapat:

Menyulitkan tim IT menghentikan atau membatalkan aksi yang sudah berjalan

Memperpanjang waktu respons saat terjadi insiden

Memperbesar dampak kesalahan karena aksi terus berlanjut sebelum terdeteksi

4. Keterbatasan visibilitas dan audit trail

Dalam banyak implementasi, aktivitas AI tidak selalu tercatat dengan tingkat detail yang sama seperti aktivitas manusia. Hal ini menciptakan celah visibilitas, terutama saat tim keamanan perlu melakukan penelusuran pasca-insiden. Padahal, visibilitas dan audit trail yang lengkap merupakan fondasi utama untuk investigasi, tata kelola, dan kepercayaan terhadap sistem otomatis.

Akibatnya:

Tim keamanan kesulitan memahami keputusan yang diambil AI

Proses audit menjadi lebih kompleks dan memakan waktu

Tanggung jawab atas sebuah aksi menjadi tidak jelas

5. Risiko kepatuhan dan tata kelola

Bagi organisasi yang beroperasi di bawah regulasi dan standar tertentu, setiap perubahan sistem harus dapat dipertanggungjawabkan. Ketika AI mulai bertindak secara mandiri, tantangan kepatuhan menjadi semakin kompleks. Karena itu, tata kelola yang jelas menjadi elemen krusial agar AI tetap mendukung kepatuhan, bukan justru menjadi sumber risiko baru.

Tanpa kontrol yang tepat, agentic AI berpotensi:

Menjalankan aksi di luar kebijakan yang ditetapkan

Menyulitkan pembuktian kepatuhan saat audit

Meningkatkan risiko temuan saat investigasi internal maupun eksternal

Best practice implementasi AI Agentic security

Agentic AI dapat mempercepat operasional IT, tetapi juga meningkatkan risiko karena AI mampu mengambil keputusan dan menjalankan aksi secara mandiri. Karena itu, keamanan agentic AI perlu dibangun dengan fokus pada kontrol, apa yang boleh dilakukan AI, kapan boleh dilakukan, dengan akses apa, serta bagaimana setiap aksinya dapat dipantau dan diaudit.

Pendekatan berikut membantu organisasi menjaga keseimbangan antara kecepatan otomatisasi dan kontrol di lingkungan IT modern.

Visibility First

Sebelum memberi AI kewenangan untuk bertindak, organisasi perlu memastikan visibilitas penuh atas aktivitas sistem dan alur kerja yang dijalankan AI. Tanpa visibilitas yang jelas, aksi otomatis berisiko menjadi blind spot yang sulit dievaluasi atau ditindaklanjuti.

Memahami perilaku normal dan anomali sejak awal, tim IT dapat menilai keputusan AI berdasarkan konteks yang tepat dan merespons insiden dengan lebih cepat.

Pastikan seluruh aktivitas AI tercatat melalui monitoring dan logging end-to-end.

Tetapkan baseline perilaku normal sebelum mengaktifkan aksi otomatis.

Sertakan konteks di setiap alert: apa yang terjadi, di sistem mana, dan dampaknya apa.

Least Privilege by Design

Agentic AI hanya boleh memiliki akses yang benar-benar dibutuhkan untuk menjalankan tugasnya. Memberikan akses luas demi kemudahan justru meningkatkan risiko kesalahan berdampak besar.

Melalui prinsip least privilege, organisasi dapat membatasi ruang gerak AI dan mengurangi potensi penyalahgunaan atau eskalasi akses yang tidak disengaja.

Berikan akses berbasis tugas, bukan akses permanen yang luas.

Pisahkan hak akses read dan write secara jelas.

Tinjau dan sesuaikan akses AI secara berkala.

Policy-Driven Actions

AI tidak boleh bertindak semata-mata berdasarkan efisiensi teknis. Setiap aksi otomatis harus dijalankan dalam kerangka kebijakan yang jelas dan terdokumentasi. Kebijakan ini berfungsi sebagai pagar pengaman agar otomatisasi tetap selaras dengan kebutuhan bisnis, keamanan, dan kepatuhan.

Definisikan aksi yang boleh dijalankan otomatis dan yang wajib approval.

Tetapkan batasan khusus untuk sistem dan data kritis.

Dokumentasikan aturan dan kebijakan yang mengatur aksi AI.

Human-in-the-Loop for High-Impact Actions

Tidak semua keputusan memerlukan campur tangan manusia, tetapi aksi dengan dampak besar tetap membutuhkan validasi tambahan. Pendekatan human-in-the-loop membantu menjaga kontrol tanpa menghilangkan manfaat otomatisasi.

Dengan validasi ini, organisasi dapat mencegah kesalahan besar sekaligus meningkatkan kepercayaan terhadap sistem AI.

Wajibkan persetujuan untuk perubahan konfigurasi kritis dan akses data sensitif.

Tentukan jalur eskalasi yang jelas untuk aksi berisiko tinggi.

Catat setiap keputusan manual yang terkait dengan aksi AI.

Auditability by Default

Setiap tindakan AI harus dapat ditelusuri kembali. Tanpa audit trail yang jelas, investigasi insiden dan pembuktian kepatuhan akan menjadi sulit.

Auditabilitas memastikan bahwa meskipun AI bekerja secara mandiri, tanggung jawab tetap berada di tangan organisasi.

Checklist

Catat waktu, konteks, dan sistem yang terlibat dalam setiap aksi AI.

Pastikan log mudah diakses untuk investigasi dan audit.

Tinjau audit trail secara berkala untuk evaluasi keamanan.

Phased and Measured Adoption

Adopsi agentic AI sebaiknya dilakukan secara bertahap, dimulai dari skenario berisiko rendah. Setiap tahap perlu dievaluasi sebelum memperluas peran dan kewenangan AI.

Pendekatan bertahap membantu organisasi mengidentifikasi risiko lebih awal dan menyesuaikan kontrol yang dibutuhkan.

Checklist

Mulai dari use case sederhana dan berisiko rendah.

Evaluasi dampak dan perilaku AI sebelum meningkatkan otonomi.

Perbarui kebijakan dan kontrol seiring perluasan implementasi.

Bagaimana ManageEngine membantu mendukung AI Agentic security?

Dalam konteks agentic AI, tantangan utama organisasi bukan sekadar mengadopsi AI, tetapi memastikan otomatisasi tetap berada dalam kerangka kontrol yang jelas. ManageEngine berperan sebagai enabler yang membantu tim IT dan keamanan menjaga keseimbangan antara kecepatan AI dan tata kelola yang kuat.

Alih-alih membiarkan AI bertindak secara bebas, pendekatan ManageEngine berfokus pada membangun fondasi kontrol, visibilitas, dan akuntabilitas di seluruh lingkungan IT. Dengan fondasi ini, organisasi dapat memanfaatkan AI untuk mempercepat operasional tanpa kehilangan kendali atas sistem kritis.

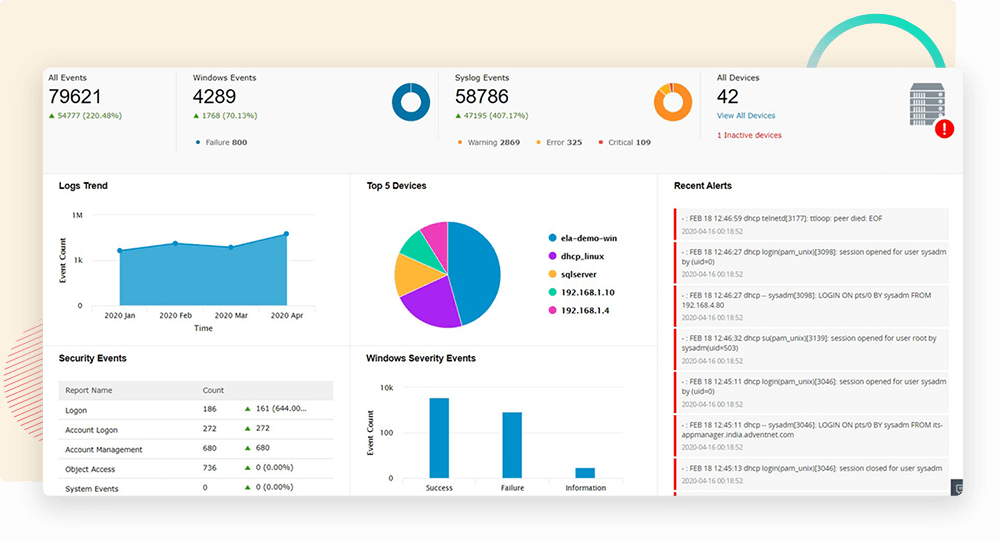

1. Visibilitas dan monitoring sebagai dasar utama

Agentic AI hanya dapat dikelola dengan baik jika organisasi memiliki visibilitas menyeluruh atas aktivitas sistem. Tanpa visibilitas terpusat, aksi otomatis termasuk yang dipicu AI berisiko menjadi blind spot bagi tim keamanan.

Pendekatan ManageEngine membantu organisasi:

Mengonsolidasikan aktivitas dari berbagai sistem dan infrastruktur

Memahami pola perilaku normal dan mendeteksi anomali

Menyediakan konteks yang jelas saat AI menjalankan aksi otomatis

Kemampuan ini biasanya didukung melalui monitoring infrastruktur dan analisis log terpusat, seperti yang tersedia di ManageEngine OpManager untuk visibilitas performa sistem dan ManageEngine Log360 untuk korelasi aktivitas keamanan.

2. Otomatisasi yang tetap berbasis rule dan kebijakan

Kami menempatkan kebijakan sebagai pusat pengambilantidakan. Setiap proses otomatis berjalan dalam kerangka aturan yang telah ditentukan, bukan semata-mata berdasarkan efisiensi teknis.

Pendekatan ini memungkinkan organisasi untuk:

Menentukan batas aman bagi aksi otomatis

Mengontrol kapan otomatisasi boleh dijalankan penuh

Mengatur kapan eskalasi atau persetujuan manual diperlukan

Prinsip ini terimplementasi dalam workflow dan approval-based automation yang umum diterapkan di ITSM dan pengelolaan endpoint, misalnya melalui ManageEngine ServiceDesk Plus dan ManageEngine Endpoint Central. Melalui cara ini, AI berperan sebagai akselerator operasional, sementara keputusan kritis tetap berada dalam kendali organisasi.

3. Pengelolaan identitas dan hak akses yang lebih ketat

Agentic AI tetap beroperasi menggunakan identitas sistem dan hak akses tertentu. Tanpa pengelolaan yang matang, AI berpotensi berjalan dengan kewenangan berlebihan, sehingga meningkatkan risiko kesalahan berdampak besar.

ManageEngine membantu organisasi menerapkan pendekatan akses yang lebih disiplin dengan:

Membatasi hak akses sesuai kebutuhan tugas

Mengurangi risiko eskalasi akses yang tidak disengaja

Memastikan setiap aksi memiliki identitas yang jelas

Pendekatan ini selaras dengan praktik pengelolaan identitas dan akses terpusat, seperti yang diterapkan melalui ManageEngine ADManager Plus dan kontrol akses istimewa di ManageEngine PAM360. AI hanya dapat melakukan apa yang memang diizinkan, tidak lebih.

4. Auditabilitas dan akuntabilitas sebagai pilar tata kelola

Kepercayaan terhadap agentic AI sangat bergantung pada kemampuan organisasi untuk menjawab satu pertanyaan mendasar: apa yang terjadi, siapa yang menjalankan, dan mengapa.

Dengan jejak audit yang konsisten, organisasi dapat:

Melakukan investigasi insiden dengan lebih cepat

Menunjukkan kepatuhan terhadap kebijakan dan regulasi

Mengevaluasi efektivitas otomatisasi berbasis AI

Auditabilitas ini biasanya diperkuat melalui pencatatan aktivitas user dan sistem, seperti yang tersedia di ManageEngine ADAudit Plus, serta analisis log terpusat. Dengan demikian, meskipun AI bekerja secara mandiri, tanggung jawab tetap berada di tangan organisasi.

Siapkah Anda menjaga kontrol dengan AI yang semakin mandiri?

Agentic AI membuka peluang besar bagi tim IT untuk bekerja lebih cepat, proaktif, dan efisien. Namun, semakin mandiri AI dalam mengambil keputusan dan menjalankan aksi, semakin penting pula pendekatan keamanan yang memastikan setiap langkah tetap terkendali.

AI agentic security bukan tentang membatasi inovasi, melainkan tentang membangun kepercayaan bahwa otomatisasi berjalan sesuai kebijakan, dapat dipantau, dan dapat dipertanggungjawabkan. Dengan fondasi visibilitas, kontrol akses, kebijakan yang jelas, serta auditabilitas yang konsisten, organisasi dapat memanfaatkan AI tanpa mengorbankan stabilitas dan kepatuhan.

Kini AI dapat menjadi pendukung strategis bagi operasional IT modern. Untuk memahami bagaimana pendekatan pengelolaan IT yang terkontrol dan terintegrasi dapat membantu organisasi Anda, silakan jelajahi solusi dan insight lainnya di ManageEngine.