¿Qué es el monitoreo de Kubernetes?

Kubernetes cambia las reglas del juego a la hora de gestionar aplicaciones en contenedores, pero comprender su compleja arquitectura y mantener un óptimo rendimiento requiere experiencia. Esta guía completa de Kubernetes, explica sus componentes clave y aborda los retos que plantea su uso en entornos dinámicos. A continuación, explica las ventajas del monitoreo de Kubernetes y las métricas clave que debe monitorear. Ya sea que esté probando Kubernetes por primera vez o buscando información avanzada para monitorear y optimizar recursos, esta guía le proporciona los conocimientos necesarios para dominar Kubernetes y mantener sus aplicaciones en perfecto funcionamiento. Siga leyendo para explorar cómo Kubernetes simplifica la gestión de aplicaciones al tiempo que permite la escalabilidad, la fiabilidad y la eficiencia.

¿Qué es Kubernetes?

Kubernetes es una plataforma de código abierto para automatizar la implementación, el escalamiento y la gestión de aplicaciones en contenedores. Kubernetes es como un gestor para su aplicación. Le ayuda a organizar y ejecutar sin problemas las partes de su aplicación (denominadas contenedores). Garantiza que su aplicación pueda crecer y reducirse según sea necesario, y que funcione bien en distintos equipos.

¿Cuáles son los beneficios de Kubernetes?

Kubernetes ofrece varias ventajas clave:

- Portabilidad: Le permite ejecutar sus aplicaciones en una gran variedad de infraestructuras, desde servidores físicos hasta entornos en la nube.

- Escalabilidad: Kubernetes puede ajustar automáticamente el número de contenedores para satisfacer la demanda cambiante, garantizando una utilización óptima de los recursos.

- Eficiencia: Las funciones de gestión de recursos de Kubernetes le ayudan a optimizar el uso de la CPU, la memoria y otros recursos.

- Fiabilidad: Kubernetes proporciona funciones como la autorreparación y el equilibrio de carga para garantizar una alta disponibilidad y tolerancia a los fallos.

Al automatizar muchas de las complejas tareas que implica la gestión de aplicaciones en contenedores, Kubernetes libera a los desarrolladores y a los equipos de operaciones, para que puedan centrarse en construir y ofrecer software innovador. Se ha convertido en el estándar de facto para ejecutar aplicaciones en contenedores en entornos de producción.

Una mirada más profunda en la arquitectura de Kubernetes

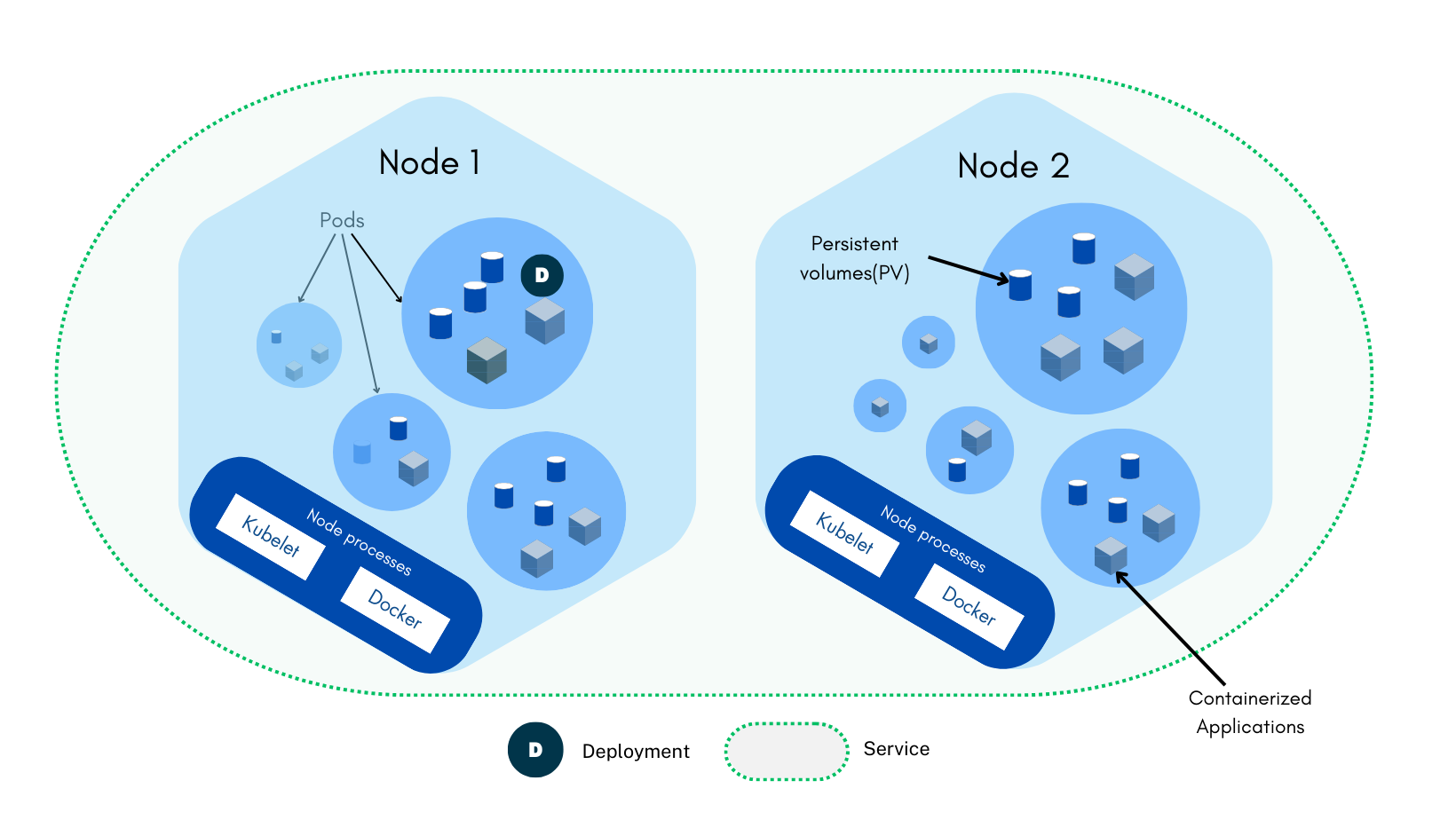

Para monitorear y gestionar eficazmente un clúster de Kubernetes, es esencial tener un sólido conocimiento de los componentes subyacentes en la arquitectura de Kubernetes. Profundicemos en los componentes básicos y sus interacciones.

¿Qué es un clúster de Kubernetes?

Un clúster de Kubernetes es un grupo de equipos (nodos), que trabajan juntos para ejecutar aplicaciones en contenedores. Es la unidad fundamental de Kubernetes, que proporciona el entorno para implementar, escalar y gestionar sus aplicaciones.

Componentes básicos de un clúster de Kubernetes

Dentro de un clúster, varias unidades trabajan en conjunto, para que el clúster de Kubernetes funcione. Estos son:

- Nodos: Son las unidades fundamentales de la arquitectura de Kubernetes; pueden ser equipos físicos o virtuales. Sirven como recursos computacionales donde se ejecutan las aplicaciones en contenedores.

- Nodo maestro: Es el cerebro del clúster, responsable de gestionar los nodos trabajadores, programar pods y mantener el estado deseado del clúster.

- Nodos trabajadores: Ejecutan pods y se comunican con el nodo maestro.

- Pods: Son las unidades desplegables más pequeñas de la arquitectura de Kubernetes y representan un grupo de uno o varios contenedores que comparten el espacio de nombres de red, el almacenamiento y la dirección IP. Son los elementos básicos para implementar aplicaciones. Aunque a menudo alojan un único contenedor, los pods pueden alojar varios contenedores juntos para casos de uso específicos.

- Contenedores: Son los entornos de ejecución aislados para las aplicaciones y sus dependencias. Son las unidades centrales de computación dentro de los pods. Empaquetan las aplicaciones y sus dependencias, garantizando su consistencia y portabilidad en distintos entornos.

- Implementaciones: Se aseguran de que un número determinado de réplicas de pod se ejecuten en un momento dado, gestionando las actualizaciones y los fallos eficazmente. Se encargan del proceso de creación, actualización y escalamiento de pods.

- Servicios: Estos abstraen un conjunto de pods como un único servicio de red para proporcionar un endpoint estable para acceder a los pods, permitiendo el equilibrio de carga y el descubrimiento de servicios.

- Espacios de nombres: Aíslan los recursos dentro de un cluster para proporcionar organización y seguridad. Permiten que varios equipos o proyectos compartan un clúster sin interferir entre sí.

Otros componentes clave en la arquitectura de Kubernetes

Además de estos componentes básicos, otros elementos contribuyen a la riqueza del entorno Kubernetes:

- ReplicaSets: Garantiza que haya un conjunto estable de réplicas de pods, que a menudo se utiliza junto con las implementaciones.

- StatefulSets: Gestiona las aplicaciones con estado que tienen almacenamiento persistente, garantizando un orden estable de los pods y unas identidades de red únicas.

- ConfigMaps y Secrets: Almacena los datos de configuración y la información sensible, respectivamente, de forma estructurada y protegida.

- Volumes: Proporciona almacenamiento persistente a los pods, garantizando la persistencia de los datos más allá del ciclo de vida del pod.

- Ingress: Expone el tráfico HTTP/HTTPS a los servicios del cluster, actuando como proxy inverso y equilibrador de carga.

El plano de control de Kubernetes

El plano de control de Kubernetes es el sistema nervioso central del clúster, responsable de orquestar y gestionar sus recursos. Comprende varios componentes interconectados que trabajan juntos para garantizar que se mantenga el estado deseado del cluster. Estos son:

Componentes básicos del plano de control

- etcd: Este almacén de valores clave distribuido y de alta disponibilidad actúa como columna vertebral del plano de control, almacenando información crucial sobre el estado del clúster, como configuraciones, secretos y estados deseados para pods, servicios e implementaciones.

- kube-apiserver: El front-end del plano de control, que proporciona una API RESTful para interactuar con los recursos del clúster. Autentica y autoriza las solicitudes, procesa las llamadas a la API e interactúa con otros componentes del plano de control.

- kube-scheduler: El componente de toma de decisiones que selecciona los nodos apropiados para ejecutar pods en función de la disponibilidad de recursos, las restricciones y las reglas de afinidad. Garantiza una utilización óptima de los recursos y la distribución de la carga de trabajo en el clúster.

- kube-controller-manager: Implementa bucles de control del núcleo que reconcilian el estado real del cluster con el estado deseado. Gestiona conjuntos de réplicas, endpoints, cuentas de servicio y eventos del ciclo de vida de los nodos.

Cómo trabajan juntos

Los componentes del plano de control interactúan de manera eficiente para mantener la salud y la estabilidad del clúster:

- Estado deseado: Los usuarios definen el estado deseado de su aplicación mediante manifiestos de Kubernetes, como implementaciones, servicios y pods.

- Interacción con la API: Kube-apiserver recibe estos manifiestos y los almacena en etcd.

- Programación: Kube-scheduler analiza los recursos del cluster y selecciona los nodos adecuados para los nuevos pods en función de las restricciones definidas.

- Gestión de controladores: Kube-controller-manager garantiza que el estado real del clúster se alinea con el estado deseado al crear, actualizar o eliminar pods según sea necesario.

- Almacenamiento del estado: Etcd almacena de forma persistente el estado del clúster, lo que permite al plano de control recuperarse de los fallos y mantener la consistencia.

Desafíos en Kubernetes

Kubernetes, aunque es una herramienta potente, presenta varios desafíos técnicos que pueden afectar al rendimiento y la fiabilidad de las aplicaciones. Profundicemos en cada uno de estos desafíos y exploremos posibles soluciones:

- Gestión del ciclo de vida de los contenedores

- Desafío: La naturaleza dinámica de Kubernetes hace que sea difícil controlar el estado de los contenedores a lo largo del tiempo.

- Soluciones:

- Aproveche las ID de los contenedores: Utilice identificadores de contenedor únicos para correlacionar logs, métricas y eventos.

- Utilice etiquetas y anotaciones: Etiquete los contenedores con metadatos para categorizar y filtrar los datos.

- Monitoree el estado del pod y de la implementación: Supervise el ciclo de vida de los pods y las implementaciones.

- Complejidad de los sistemas distribuidos

- Desafío: Comprender las interacciones entre microservicios en un entorno distribuido puede resultar complejo.

- Soluciones:

- Seguimiento distribuido: Utilice herramientas como Jaeger o Zipkin para supervisar los flujos de solicitudes en los microservicios.

- Malla de servicio: Implemente una malla de servicio para simplificar la gestión de la red y proporcionar observabilidad.

- Correlación de métricas y logs: Relacione las métricas y logs de los distintos componentes para identificar problemas.

- Asignación de recursos y utilización

- Desafío: Garantizar una asignación de recursos óptima sin sobreaprovisionamiento ni infrautilización de recursos.

- Soluciones:

- Monitoree el uso de los recursos: Supervise las métricas de CPU, memoria, red y E/S de disco.

- Implemente el escalado automático: Escale automáticamente las aplicaciones en función de la demanda.

- Optimice las solicitudes de recursos: Ajuste las solicitudes de recursos para los pods.

- Gestión de redes

- Desafío: Diagnosticar problemas de red en un entorno Kubernetes complejo.

- Soluciones:

- Monitoreo de red: Utilice herramientas para monitorear el tráfico de red, la latencia y la pérdida de paquetes.

- Políticas de red: Aplique normas de aislamiento y seguridad de la red.

- Almacenamiento persistente

- Desafío: Garantizar la consistencia y la disponibilidad de los datos en un entorno dinámico.

- Soluciones:

- StatefulSets: Utilice StatefulSets para aplicaciones que requieran un almacenamiento persistente e identidades de red estables.

- Volúmenes persistentes: Aprovisione volúmenes de almacenamiento persistente para pods.

- Estrategias de respaldo y restauración: Implemente copias de seguridad periódicas y planes de recuperación ante desastres.

- Seguridad y cumplimiento

- Desafío: Proteger el clúster de Kubernetes y las aplicaciones frente a vulnerabilidades y amenazas.

- Soluciones:

- Control de acceso basado en roles (RBAC): Restrinja el acceso a los recursos en función de los roles.

- Seguridad de la red: Implemente políticas de red y firewalls.

- Análisis de vulnerabilidades: Analice periódicamente en busca de vulnerabilidades y aplique parches a los sistemas.

- Monitoreo del cumplimiento: Garantice el cumplimiento de las normas de seguridad y reglamentarias.

¿Qué es el monitoreo de Kubernetes?

El monitoreo de Kubernetes implica monitorear, recopilar, analizar y gestionar métricas, logs y eventos de clústeres, nodos, pods, contenedores y cargas de trabajo de Kubernetes. Este proceso garantiza la salud, el rendimiento y la fiabilidad de las aplicaciones que funcionan en la plataforma Kubernetes.

Beneficios de usar un sistema de monitoreo de Kubernetes

Al usar una solución integral para el monitoreo, las organizaciones pueden obtener los siguientes beneficios:

- Mejor rendimiento de las aplicaciones: Identifique y solucione los cuellos de botella en el rendimiento para mejorar la experiencia del usuario.

- Mayor fiabilidad: Detecte y resuelva proactivamente los problemas antes de que afecten a la disponibilidad.

- Escalabilidad: Monitoree los eventos de escalado para garantizar que el clúster satisface las demandas de carga de trabajo.

- Utilización optimizada de los recursos: Evite el aprovisionamiento excesivo o la infrautilización de recursos, con el consiguiente ahorro de costos.

- Mejor visibilidad: Las herramientas de monitoreo centralizadas proporcionan una visión holística del clúster de Kubernetes, facilitando la gestión de implementaciones complejas

¿Por qué es importante el monitoreo de Kubernetes?

El monitoreo de Kubernetes es fundamental para garantizar el éxito de sus cargas de trabajo contenedorizadas.

- Garantiza la alta disponibilidad: El monitoreo es fundamental para mantener el tiempo de actividad y la fiabilidad de las aplicaciones, garantizando que cumplan los acuerdos de nivel de servicio (SLA).

- Apoya la continuidad empresarial: Al detectar y mitigar los problemas en una fase temprana, el monitoreo minimiza las interrupciones y garantiza un funcionamiento ininterrumpido de la empresa.

- Refuerza la seguridad: El monitoreo ayuda a identificar actividades sospechosas, como accesos no autorizados o uso indebido de recursos, mejorando la postura de seguridad general.

- Facilita el cumplimiento: Para las industrias reguladas, el monitoreo proporciona pistas de auditoría y logs de rendimiento, ayudando a cumplir con los requisitos de cumplimiento.

- Permite tomar decisiones basadas en datos: Los datos históricos en tiempo real de las herramientas de monitoreo permiten a los equipos tomar decisiones informadas sobre las mejoras de la infraestructura y las aplicaciones.

Al monitorear efectivamente su entorno Kubernetes, puede garantizar la salud, el rendimiento y la seguridad de sus aplicaciones, al tiempo que minimiza los riesgos operativos y maximiza el retorno de la inversión.

Obtenga un resumen general de las métricas clave de Kubernetes

El monitoreo de Kubernetes requiere un enfoque multifacético, en el que se controlan las métricas a través de varios componentes para obtener una visión holística de la salud del clúster y el rendimiento de la aplicación. Aquí hay un desglose detallado de las métricas esenciales:

Métricas a nivel de nodo

- Uso de la CPU: Monitoree la utilización de la CPU para identificar cuellos de botella en los recursos y posibles necesidades de escalado.

- Uso de la memoria: Supervise el consumo de memoria para evitar el agotamiento de los recursos y garantizar que la aplicación se ejecute de manera fluida.

- E/S de disco: Mida las operaciones de lectura/escritura del disco para evaluar el rendimiento del almacenamiento e identificar posibles cuellos de botella de E/S.

- Tráfico de red: Monitoree el tráfico de la red para identificar las limitaciones de ancho de banda y los posibles problemas de la red.

Métricas a nivel de pod y de contenedor

- Uso de CPU y memoria: Evalúe el uso de recursos a nivel de pod y de contenedor para localizar los cuellos de botella en el rendimiento y optimizar la asignación de recursos.

- Reinicios de pods: Supervise los reinicios de los pods para identificar problemas recurrentes o problemas de configuración.

- Tiempo de actividad del contenedor: Monitoree el tiempo de actividad de los contenedores para evaluar la disponibilidad y estabilidad de las aplicaciones.

- Solicitudes y límites de recursos: Asegúrese de que los contenedores estén configurados con las solicitudes de recursos y los límites adecuados para evitar la contención de recursos.

Métricas a nivel de cluster

- Latencia del servidor API: Mida la capacidad de respuesta del servidor API de Kubernetes para evaluar el rendimiento del clúster e identificar posibles cuellos de botella.

- Rendimiento del programador: Evalúe la eficiencia del programador a la hora de asignar pods a los nodos, para optimizar la utilización de los recursos.

- Salud del plano de control: Monitoree el estado y el rendimiento de los componentes del plano de control central (etcd, kube-scheduler, kube-controller-manager), para garantizar la estabilidad del clúster.

Métricas a nivel de aplicación

- Latencia de la solicitud: Supervise el tiempo que tardan sus aplicaciones en procesar las solicitudes para identificar problemas de rendimiento y optimizar los tiempos de respuesta.

- Tasas de error: Monitoree las tasas de error para localizar los fallos de la aplicación y solucionar los problemas.

- Rendimiento: Mida el número de solicitudes procesadas durante un periodo determinado para evaluar la capacidad y el rendimiento de la aplicación.

Métricas a nivel de red

- Latencia de la red de pods: Mida la latencia de la comunicación de red entre pods, para identificar los cuellos de botella de rendimiento relacionados con la red.

- Paquetes perdidos: Monitoree el número de paquetes perdidos para diagnosticar problemas de red y garantizar una comunicación fiable.

- Aplicación de políticas de red: Supervise la aplicación de las políticas de red para garantizar la seguridad y el aislamiento.

Métricas a nivel de nodo

- Salud del volumen: Monitoree el estado de salud de los volúmenes persistentes para garantizar la disponibilidad y consistencia de los datos.

- Latencia de E/S: Mida la latencia de las operaciones de entrada/salida en los volúmenes de almacenamiento, para identificar los cuellos de botella en el rendimiento.

- Uso y capacidad: Supervise el uso y la capacidad de almacenamiento, para evitar quedarse sin espacio.

Al monitorear estas métricas clave, puede obtener información valiosa sobre la salud y el rendimiento de su clúster de Kubernetes y sus aplicaciones, lo que le permite identificar y abordar proactivamente los problemas, optimizar la utilización de los recursos y garantizar una experiencia de usuario óptima.

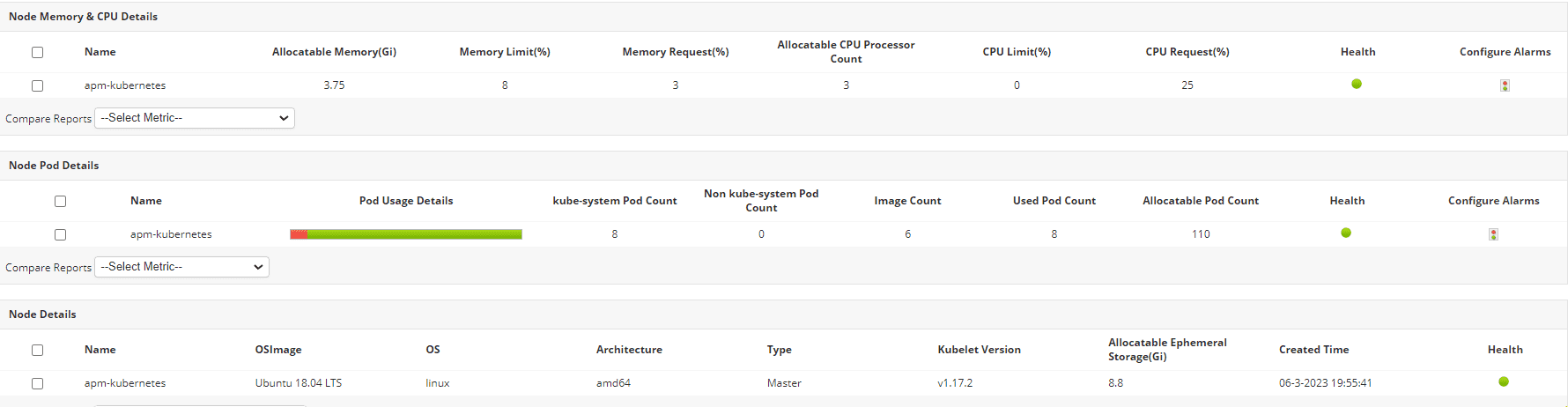

Monitoreo de Kubernetes con ManageEngine Applications Manager

ManageEngine Applications Manager es una potente herramienta diseñada para simplificar el monitoreo de Kubernetes. Ofrece un conjunto completo de funciones que proporcionan una visibilidad profunda de la salud y el rendimiento de su clúster. Applications Manager se integra de manera eficiente en su entorno Kubernetes para recopilar y analizar datos de diversos componentes. Proporciona monitoreo en tiempo real, alertas y datos históricos para ayudarle a tomar decisiones informadas. El monitor de Kubernetes en Applications Manager también cuenta con una interfaz intuitiva y fácil de usar que transforma los datos complejos en información procesable.

Principales funciones del monitor de Kubernetes de Applications Manager

Estas son algunas de las funciones principales para el monitoreo de Kubernetes que ofrece Applications Manager:

- Monitoreo de la salud de los nodos: Supervise la utilización de CPU, memoria, E/S de disco y red de cada nodo para identificar posibles cuellos de botella.

- Monitoreo del rendimiento del pod: Monitoree el estado de los pods, el consumo de recursos y el recuento de reinicios para optimizar el comportamiento de los pods y solucionar problemas.

- Información sobre los contenedores: Obtenga visibilidad del estado de cada contenedor y del uso de recursos para localizar los contenedores que consumen muchos recursos y optimizar su rendimiento.

- Supervisión del estado de la implementación: Supervise el progreso y la salud de sus implementaciones de Kubernetes para evitar problemas en la entrega de aplicaciones.

- Métricas para todo el clúster: Evalúe la utilización general de los recursos, la capacidad del clúster y la latencia del servidor API para planificar y optimizar la capacidad

¿Necesita monitorear sus contenedores y aplicaciones de Kubernetes?

Eleve su monitoreo de Kubernetes con Applications Manager. Descárguelo ahora y experimente la diferencia. O programe una demostración personalizada para realizar una visita guiada.

>

Angeline, analista de marketing

Angeline forma parte del equipo de marketing de ManageEngine. Le encanta explorar el espacio tecnológico, especialmente la observabilidad, DevOps y AIOps. Con su habilidad para simplificar temas complejos, ayuda a los lectores a navegar por el cambiante panorama tecnológico.

Preguntas frecuentes sobre el monitoreo de Kubernetes

¿Cuál es el objetivo principal de Kubernetes?

+

El objetivo principal de Kubernetes es automatizar la implementación, el escalado y la gestión de aplicaciones en contenedores. Proporciona una plataforma para orquestar contenedores (por ejemplo, Docker) a través de clústeres de equipos, garantizando que las aplicaciones se ejecuten de forma eficiente, fiable y a escala.

- Implementación automatizada: Simplifica el rollout y la actualización de las aplicaciones.

- Escalamiento: Ajusta automáticamente los recursos en función de la demanda.

- Equilibrio de carga: Distribuye el tráfico uniformemente entre los contenedores.

- Auto reparación: Reinicia o reemplaza los contenedores con errores.

- Gestión de recursos: Optimiza el uso de la CPU, la memoria y el almacenamiento.

Kubernetes permite a los desarrolladores centrarse en desarrollar aplicaciones mientras se encarga de las complejidades de la infraestructura y las operaciones.

¿Cuál es la mejor herramienta para el monitoreo de Kubernetes?

+

La mejor herramienta para el monitoreo de Kubernetes depende de sus necesidades específicas, pero ManageEngine Applications Manager es una herramienta polivalente que ayuda a monitorear de forma exhaustiva los contenedores, las aplicaciones Kubernetes y la infraestructura de la que dependen las aplicaciones. Otras herramientas son Datadog, Dynatrace, New Relic, Prometheus+Grafana, Elastic y Kubecost.

¿Qué es un monitor de servicio en Kubernetes?

+

En Kubernetes, ServiceMonitor es un recurso personalizado que el operador de Prometheus utiliza para definir cómo Prometheus debe monitorear los servicios específicos. Automatiza el descubrimiento de servicios y la extracción de métricas especificando qué servicios, espacios de nombres o etiquetas se deben monitorear, junto con detalles como intervalos y rutas de extracción. Por ejemplo, puede dirigirse a servicios con etiquetas específicas y recopilar métricas de sus endpoints. Esto simplifica la configuración del monitoreo en entornos Kubernetes dinámicos. ServiceMonitor es esencial para integrar Prometheus con Kubernetes, permitiendo monitorear de forma eficiente y automatizada microservicios y aplicaciones sin intervención manual. Se utiliza mucho en entornos de observabilidad.

¿Cómo puedo monitorear la implementación de Kubernetes?

+

El monitoreo de Kubernetes requiere un enfoque por capas y se puede gestionar eficazmente utilizando una herramienta dedicada como ManageEngine Applications Manager. Empiece aprovechando herramientas nativas como kubectl para comprobar el estado y logs, y active el servidor de métricas para recopilar datos sobre el uso de los recursos. Luego, las herramientas de monitoreo pueden recopilar y visualizar métricas críticas como CPU, memoria y tasas de solicitud. Céntrese en controlar las métricas esenciales como el estado de los pods, la utilización de los recursos y las tasas de error. Configure alertas para que le notifiquen sobre el consumo elevado de recursos, los fallos en los pods o los tiempos de respuesta lentos. Además, agregar y analizar las métricas de rendimiento puede ayudar a predecir tendencias futuras, garantizando que su implementación funcione de forma eficiente y que los posibles problemas se identifiquen de forma proactiva.